基于S2奖励机制优化的智能决策系统研究与应用分析

- 44

文章摘要:

DG视讯官网平台基于S2奖励机制优化的智能决策系统是一种通过强化学习理论对传统决策系统进行创新和优化的智能化方法。本文首先从S2奖励机制的基本概念和发展背景入手,阐述了其在智能决策中的应用价值。接着,本文分别从S2奖励机制的核心算法原理、其在智能决策系统中的实现方式、在实际应用中的优势与挑战,以及未来发展趋势四个方面,深入探讨了基于S2奖励机制优化的智能决策系统的研究成果与应用前景。文章指出,S2奖励机制不仅能够提高决策效率和准确性,还能在复杂动态环境下实现持续学习与自我优化,为智能系统的自适应决策提供了强有力的支持。最后,文章总结了该技术的现状与未来发展潜力,展望了其在更多领域的广泛应用。

1、S2奖励机制的核心原理

在智能决策系统中,奖励机制起着至关重要的作用。S2奖励机制作为一种创新的优化方法,其核心理念是通过精细化的奖励设计,引导智能体在动态环境中通过试错学习不断优化决策过程。S2奖励机制的“2”代表的是在奖励评估中,智能体需要考虑到多维度的反馈信号,包括即时奖励和长期奖励两个层面的权衡。这种机制不同于传统的单一奖励方式,它强调不仅仅关注短期的回报,还能在长远角度上提升系统的决策质量。

具体来说,S2奖励机制采用了多次迭代的方式来优化奖励分配。智能体在每一次决策过程中,都会根据环境的反馈调整奖励策略,从而使得在长期学习过程中,智能体能够逐渐找到最佳决策路径。与传统的强化学习方法相比,S2奖励机制通过双重奖励反馈机制有效缓解了训练过程中的不稳定性问题,进一步提升了系统的学习效率和决策精度。

此外,S2奖励机制还能够通过引入环境中的实时变化来调整奖励策略。在复杂的动态环境中,传统的静态奖励机制往往会导致智能决策系统无法应对突发的环境变化。而S2奖励机制的灵活性和动态性使得它能够实时根据环境反馈调整学习策略,从而提高决策系统的自适应能力。

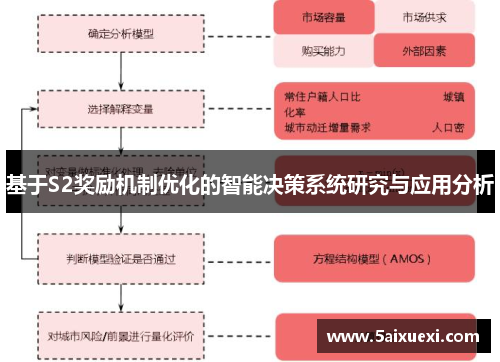

2、S2奖励机制在智能决策中的实现方式

在智能决策系统中,S2奖励机制的实现方式通常需要依托深度学习和强化学习等先进的算法框架。首先,智能体通过与环境的交互,获得状态、动作以及奖励的反馈信息。通过不断迭代,智能体在每个时间步上都会选择最优的动作以最大化长期回报。在此过程中,S2奖励机制的关键在于如何精确计算每个决策的即时奖励与未来奖励的加权值。

实现S2奖励机制的一个重要方法是采用双重Q学习(Double Q-learning)算法。与传统的Q学习算法不同,双重Q学习通过分开估计即时奖励和未来奖励的价值,避免了过度估计未来奖励带来的偏差。这种方法特别适用于需要处理大规模状态空间和动作空间的复杂智能决策问题,如自动驾驶、机器人控制等领域。

此外,为了进一步优化决策效果,S2奖励机制还常常与其他技术如深度神经网络(DNN)结合使用。深度学习能够有效处理复杂的数据输入和输出映射,使得智能体可以从海量数据中提取有价值的信息,提高决策的精确性和智能化程度。例如,在医疗诊断领域,通过深度神经网络与S2奖励机制结合,智能系统可以在大量历史病例数据中找到潜在规律,从而做出更加精准的诊断决策。

3、基于S2奖励机制的智能决策系统的优势

基于S2奖励机制优化的智能决策系统相比传统的决策方法具有诸多优势。首先,S2奖励机制能够更好地平衡短期奖励与长期回报,避免了传统决策系统中因过度关注短期目标而导致的局部最优解问题。通过在决策过程中综合考虑即时反馈和未来影响,S2奖励机制能够帮助智能系统在复杂的环境中做出更加稳健的决策。

其次,S2奖励机制具有较强的自适应能力。在动态环境中,系统需要实时根据外部环境变化调整决策策略。传统的决策系统往往只能处理静态环境中的决策任务,而S2奖励机制能够通过动态调整奖励策略,帮助智能决策系统在快速变化的环境中保持高效运作。例如,在金融领域,股市的波动性较大,S2奖励机制能够帮助智能投资决策系统根据市场变化不断优化投资策略,提高盈利能力。

最后,S2奖励机制在提升决策质量的同时,还能够有效减少计算开销。通过精确的奖励设计和反馈机制,S2奖励机制能够减少不必要的计算和资源浪费。智能体在学习过程中不再需要处理大量的无效信息,而是专注于那些对决策有实际影响的因素,从而提高系统的整体效率。

4、基于S2奖励机制的智能决策系统的挑战与发展方向

尽管基于S2奖励机制的智能决策系统具有显著的优势,但在实际应用中仍面临一定的挑战。首先,S2奖励机制对环境的建模要求较高。在一些复杂的动态环境中,准确建模环境的状态和奖励机制是一个巨大的挑战。如果模型不准确,可能会导致智能体学习到错误的决策策略,从而影响系统的性能。

其次,S2奖励机制的计算复杂度较高。在处理大规模的决策问题时,尤其是在多维度状态和动作空间下,S2奖励机制可能需要大量的计算资源来进行训练和优化。这对于计算能力有限的系统而言,可能会成为实现这一机制的瓶颈。

未来,随着深度学习和计算能力的不断进步,基于S2奖励机制的智能决策系统有望得到更广泛的应用。为了克服当前的挑战,研究者们正在探索更高效的算法和技术。例如,借助分布式计算和云计算平台,可以有效提升计算能力,减少S2奖励机制的实现成本。同时,随着多智能体系统和自主学习技术的发展,S2奖励机制将在更多领域中展现出其巨大的潜力。

总结:

基于S2奖励机制优化的智能决策系统作为一种创新的决策方法,在理论和实践中都展示了其独特的优势。通过双重奖励机制的设计,S2奖励机制能够有效提高智能决策系统在动态环境中的自适应能力和决策精度。同时,结合深度学习和强化学习等技术,S2奖励机制在解决复杂问题方面展现出了强大的潜力。尽管存在一定的挑战,但随着技术的进步,未来这种基于S2奖励机制的优化方法将在更多领域中得到广泛应用。

总体而言,S2奖励机制优化的智能决策系统不仅能够提升系统的决策能力和效率,还能在快速变化的环境中提供持续学习和优化的能力。随着人工智能技术的不断发展,基于S2奖励机制的决策系统将成为智能化应用的重要组成部分,在自动驾驶、智能金融、医疗诊断等多个领域发挥越来越重要的作用。